Transformer升级之路:2、博采众长的旋转式位置编码

By 苏剑林 | 2021-03-23 | 573487位读者 |上一篇文章中,我们对原始的Sinusoidal位置编码做了较为详细的推导和理解,总的感觉是Sinusoidal位置编码是一种“想要成为相对位置编码的绝对位置编码”。一般来说,绝对位置编码具有实现简单、计算速度快等优点,而相对位置编码则直接地体现了相对位置信号,跟我们的直观理解吻合,实际性能往往也更好。由此可见,如果可以通过绝对位置编码的方式实现相对位置编码,那么就是“集各家之所长”、“鱼与熊掌兼得”了。Sinusoidal位置编码隐约做到了这一点,但并不够好。

本文将会介绍我们自研的Rotary Transformer(RoFormer)模型,它的主要改动是应用了笔者构思的“旋转式位置编码(Rotary Position Embedding,RoPE)”,这是一种配合Attention机制能达到“绝对位置编码的方式实现相对位置编码”的设计。而也正因为这种设计,它还是目前唯一一种可用于线性Attention的相对位置编码。

基本思路 #

在之前的文章《让研究人员绞尽脑汁的Transformer位置编码》中我们就简要介绍过RoPE,当时称之为“融合式”,本文则更加详细地介绍它的来源与性质。在RoPE中,我们的出发点就是“通过绝对位置编码的方式实现相对位置编码”,这样做既有理论上的优雅之处,也有实践上的实用之处,比如它可以拓展到线性Attention中就是主要因为这一点。

为了达到这个目的,我们假设通过下述运算来给$\boldsymbol{q},\boldsymbol{k}$添加绝对位置信息:

\begin{equation}\tilde{\boldsymbol{q}}_m = \boldsymbol{f}(\boldsymbol{q}, m), \quad\tilde{\boldsymbol{k}}_n = \boldsymbol{f}(\boldsymbol{k}, n)\end{equation}

也就是说,我们分别为$\boldsymbol{q},\boldsymbol{k}$设计操作$\boldsymbol{f}(\cdot, m),\boldsymbol{f}(\cdot, n)$,使得经过该操作后,$\tilde{\boldsymbol{q}}_m,\tilde{\boldsymbol{k}}_n$就带有了位置$m,n$的绝对位置信息。Attention的核心运算是内积,所以我们希望的内积的结果带有相对位置信息,因此假设存在恒等关系:

\begin{equation}\langle\boldsymbol{f}(\boldsymbol{q}, m), \boldsymbol{f}(\boldsymbol{k}, n)\rangle = g(\boldsymbol{q},\boldsymbol{k},m-n)\end{equation}

所以我们要求出该恒等式的一个(尽可能简单的)解。求解过程还需要一些初始条件,显然我们可以合理地设$\boldsymbol{f}(\boldsymbol{q}, 0)=\boldsymbol{q}$和$\boldsymbol{f}(\boldsymbol{k}, 0)=\boldsymbol{k}$。

求解过程 #

同上一篇思路一样,我们先考虑二维情形,然后借助复数来求解。在复数中有$\langle\boldsymbol{q},\boldsymbol{k}\rangle=\text{Re}[\boldsymbol{q}\boldsymbol{k}^*]$,$\text{Re}[]$代表复数的实部,所以我们有

\begin{equation}\text{Re}[\boldsymbol{f}(\boldsymbol{q}, m)\boldsymbol{f}^*(\boldsymbol{k}, n)] = g(\boldsymbol{q},\boldsymbol{k},m-n)\end{equation}

简单起见,我们假设存在复数$\boldsymbol{g}(\boldsymbol{q},\boldsymbol{k},m-n)$,使得$\boldsymbol{f}(\boldsymbol{q}, m)\boldsymbol{f}^*(\boldsymbol{k}, n) = \boldsymbol{g}(\boldsymbol{q},\boldsymbol{k},m-n)$,然后我们用复数的指数形式,设

\begin{equation}\begin{aligned}

\boldsymbol{f}(\boldsymbol{q}, m) =&\, R_f (\boldsymbol{q}, m)e^{\text{i}\Theta_f(\boldsymbol{q}, m)} \\

\boldsymbol{f}(\boldsymbol{k}, n) =&\, R_f (\boldsymbol{k}, n)e^{\text{i}\Theta_f(\boldsymbol{k}, n)} \\

\boldsymbol{g}(\boldsymbol{q}, \boldsymbol{k}, m-n) =&\, R_g (\boldsymbol{q}, \boldsymbol{k}, m-n)e^{\text{i}\Theta_g(\boldsymbol{q}, \boldsymbol{k}, m-n)} \\

\end{aligned}\end{equation}

那么代入方程后就得到方程组

\begin{equation}\begin{aligned}

R_f (\boldsymbol{q}, m) R_f (\boldsymbol{k}, n) =&\, R_g (\boldsymbol{q}, \boldsymbol{k}, m-n) \\

\Theta_f (\boldsymbol{q}, m) - \Theta_f (\boldsymbol{k}, n) =&\, \Theta_g (\boldsymbol{q}, \boldsymbol{k}, m-n)

\end{aligned}\end{equation}

对于第一个方程,代入$m=n$得到

\begin{equation}R_f (\boldsymbol{q}, m) R_f (\boldsymbol{k}, m) = R_g (\boldsymbol{q}, \boldsymbol{k}, 0) = R_f (\boldsymbol{q}, 0) R_f (\boldsymbol{k}, 0) = \Vert \boldsymbol{q}\Vert \Vert \boldsymbol{k}\Vert\end{equation}

最后一个等号源于初始条件$\boldsymbol{f}(\boldsymbol{q}, 0)=\boldsymbol{q}$和$\boldsymbol{f}(\boldsymbol{k}, 0)=\boldsymbol{k}$。所以现在我们可以很简单地设$R_f (\boldsymbol{q}, m)=\Vert \boldsymbol{q}\Vert, R_f (\boldsymbol{k}, m)=\Vert \boldsymbol{k}\Vert$,即它不依赖于$m$。至于第二个方程,同样代入$m=n$得到

\begin{equation}\Theta_f (\boldsymbol{q}, m) - \Theta_f (\boldsymbol{k}, m) = \Theta_g (\boldsymbol{q}, \boldsymbol{k}, 0) = \Theta_f (\boldsymbol{q}, 0) - \Theta_f (\boldsymbol{k}, 0) = \Theta (\boldsymbol{q}) - \Theta (\boldsymbol{k})\end{equation}

这里的$\Theta (\boldsymbol{q}),\Theta (\boldsymbol{k})$是$\boldsymbol{q},\boldsymbol{k}$本身的幅角,最后一个等号同样源于初始条件。根据上式得到$\Theta_f (\boldsymbol{q}, m) - \Theta (\boldsymbol{q}) = \Theta_f (\boldsymbol{k}, m) - \Theta (\boldsymbol{k})$,所以$\Theta_f (\boldsymbol{q}, m) - \Theta (\boldsymbol{q})$应该是一个只与$m$相关、跟$\boldsymbol{q}$无关的函数,记为$\varphi(m)$,即$\Theta_f (\boldsymbol{q}, m) = \Theta (\boldsymbol{q}) + \varphi(m)$。接着代入$n=m-1$,整理得到

\begin{equation}\varphi(m) - \varphi(m-1) = \Theta_g (\boldsymbol{q}, \boldsymbol{k}, 1) + \Theta (\boldsymbol{k}) - \Theta (\boldsymbol{q})\end{equation}

即$\{\varphi(m)\}$是等差数列,设右端为$\theta$,那么就解得$\varphi(m)=m\theta$。

编码形式 #

综上,我们得到二维情况下用复数表示的RoPE:

\begin{equation}

\boldsymbol{f}(\boldsymbol{q}, m) = R_f (\boldsymbol{q}, m)e^{\text{i}\Theta_f(\boldsymbol{q}, m)}

= \Vert q\Vert e^{\text{i}(\Theta(\boldsymbol{q}) + m\theta)} = \boldsymbol{q} e^{\text{i}m\theta}\end{equation}

根据复数乘法的几何意义,该变换实际上对应着向量的旋转,所以我们称之为“旋转式位置编码”,它还可以写成矩阵形式:

\begin{equation}

\boldsymbol{f}(\boldsymbol{q}, m) =\begin{pmatrix}\cos m\theta & -\sin m\theta\\ \sin m\theta & \cos m\theta\end{pmatrix} \begin{pmatrix}q_0 \\ q_1\end{pmatrix}\end{equation}

由于内积满足线性叠加性,因此任意偶数维的RoPE,我们都可以表示为二维情形的拼接,即

\begin{equation}\scriptsize{\underbrace{\begin{pmatrix}

\cos m\theta_0 & -\sin m\theta_0 & 0 & 0 & \cdots & 0 & 0 \\

\sin m\theta_0 & \cos m\theta_0 & 0 & 0 & \cdots & 0 & 0 \\

0 & 0 & \cos m\theta_1 & -\sin m\theta_1 & \cdots & 0 & 0 \\

0 & 0 & \sin m\theta_1 & \cos m\theta_1 & \cdots & 0 & 0 \\

\vdots & \vdots & \vdots & \vdots & \ddots & \vdots & \vdots \\

0 & 0 & 0 & 0 & \cdots & \cos m\theta_{d/2-1} & -\sin m\theta_{d/2-1} \\

0 & 0 & 0 & 0 & \cdots & \sin m\theta_{d/2-1} & \cos m\theta_{d/2-1} \\

\end{pmatrix}}_{\boldsymbol{\mathcal{R}}_m} \begin{pmatrix}q_0 \\ q_1 \\ q_2 \\ q_3 \\ \vdots \\ q_{d-2} \\ q_{d-1}\end{pmatrix}}\end{equation}

也就是说,给位置为$m$的向量$\boldsymbol{q}$乘上矩阵$\boldsymbol{\mathcal{R}}_m$、位置为$n$的向量$\boldsymbol{k}$乘上矩阵$\boldsymbol{\mathcal{R}}_n$,用变换后的$\boldsymbol{Q},\boldsymbol{K}$序列做Attention,那么Attention就自动包含相对位置信息了,因为成立恒等式:

\begin{equation}(\boldsymbol{\mathcal{R}}_m \boldsymbol{q})^{\top}(\boldsymbol{\mathcal{R}}_n \boldsymbol{k}) = \boldsymbol{q}^{\top} \boldsymbol{\mathcal{R}}_m^{\top}\boldsymbol{\mathcal{R}}_n \boldsymbol{k} = \boldsymbol{q}^{\top} \boldsymbol{\mathcal{R}}_{n-m} \boldsymbol{k}\end{equation}

值得指出的是,$\boldsymbol{\mathcal{R}}_m$是一个正交矩阵,它不会改变向量的模长,因此通常来说它不会改变原模型的稳定性。

由于$\boldsymbol{\mathcal{R}}_m$的稀疏性,所以直接用矩阵乘法来实现会很浪费算力,推荐通过下述方式来实现RoPE:

\begin{equation}\begin{pmatrix}q_0 \\ q_1 \\ q_2 \\ q_3 \\ \vdots \\ q_{d-2} \\ q_{d-1}

\end{pmatrix}\otimes\begin{pmatrix}\cos m\theta_0 \\ \cos m\theta_0 \\ \cos m\theta_1 \\ \cos m\theta_1 \\ \vdots \\ \cos m\theta_{d/2-1} \\ \cos m\theta_{d/2-1}

\end{pmatrix} + \begin{pmatrix}-q_1 \\ q_0 \\ -q_3 \\ q_2 \\ \vdots \\ -q_{d-1} \\ q_{d-2}

\end{pmatrix}\otimes\begin{pmatrix}\sin m\theta_0 \\ \sin m\theta_0 \\ \sin m\theta_1 \\ \sin m\theta_1 \\ \vdots \\ \sin m\theta_{d/2-1} \\ \sin m\theta_{d/2-1}

\end{pmatrix}\end{equation}

其中$\otimes$是逐位对应相乘,即Numpy、Tensorflow等计算框架中的$*$运算。从这个实现也可以看到,RoPE可以视为是乘性位置编码的变体。

远程衰减 #

可以看到,RoPE形式上和Sinusoidal位置编码有点相似,只不过Sinusoidal位置编码是加性的,而RoPE可以视为乘性的。在$\theta_i$的选择上,我们同样沿用了Sinusoidal位置编码的方案,即$\theta_i = 10000^{-2i/d}$,它可以带来一定的远程衰减性。

具体证明如下:将$\boldsymbol{q},\boldsymbol{k}$两两分组后,它们加上RoPE后的内积可以用复数乘法表示为

\begin{equation}

(\boldsymbol{\mathcal{R}}_m \boldsymbol{q})^{\top}(\boldsymbol{\mathcal{R}}_n \boldsymbol{k}) = \text{Re}\left[\sum_{i=0}^{d/2-1}\boldsymbol{q}_{[2i:2i+1]}\boldsymbol{k}_{[2i:2i+1]}^* e^{\text{i}(m-n)\theta_i}\right]\end{equation}

记$h_i = \boldsymbol{q}_{[2i:2i+1]}\boldsymbol{k}_{[2i:2i+1]}^*, S_j = \sum\limits_{i=0}^{j-1} e^{\text{i}(m-n)\theta_i}$,并约定$h_{d/2}=0,S_0=0$,那么由Abel变换(分部求和法)可以得到:

\begin{equation}\sum_{i=0}^{d/2-1}\boldsymbol{q}_{[2i:2i+1]}\boldsymbol{k}_{[2i:2i+1]}^* e^{\text{i}(m-n)\theta_i} = \sum_{i=0}^{d/2-1} h_i (S_{i

+1} - S_i) = -\sum_{i=0}^{d/2-1} S_{i+1}(h_{i+1} - h_i)\end{equation}

所以

\begin{equation}\begin{aligned}

\left|\sum_{i=0}^{d/2-1}\boldsymbol{q}_{[2i:2i+1]}\boldsymbol{k}_{[2i:2i+1]}^* e^{\text{i}(m-n)\theta_i}\right| =&\, \left|\sum_{i=0}^{d/2-1} S_{i+1}(h_{i+1} - h_i)\right| \\

\leq&\, \sum_{i=0}^{d/2-1} |S_{i+1}| |h_{i+1} - h_i| \\

\leq&\, \left(\max_i |h_{i+1} - h_i|\right)\sum_{i=0}^{d/2-1} |S_{i+1}|

\end{aligned}\end{equation}

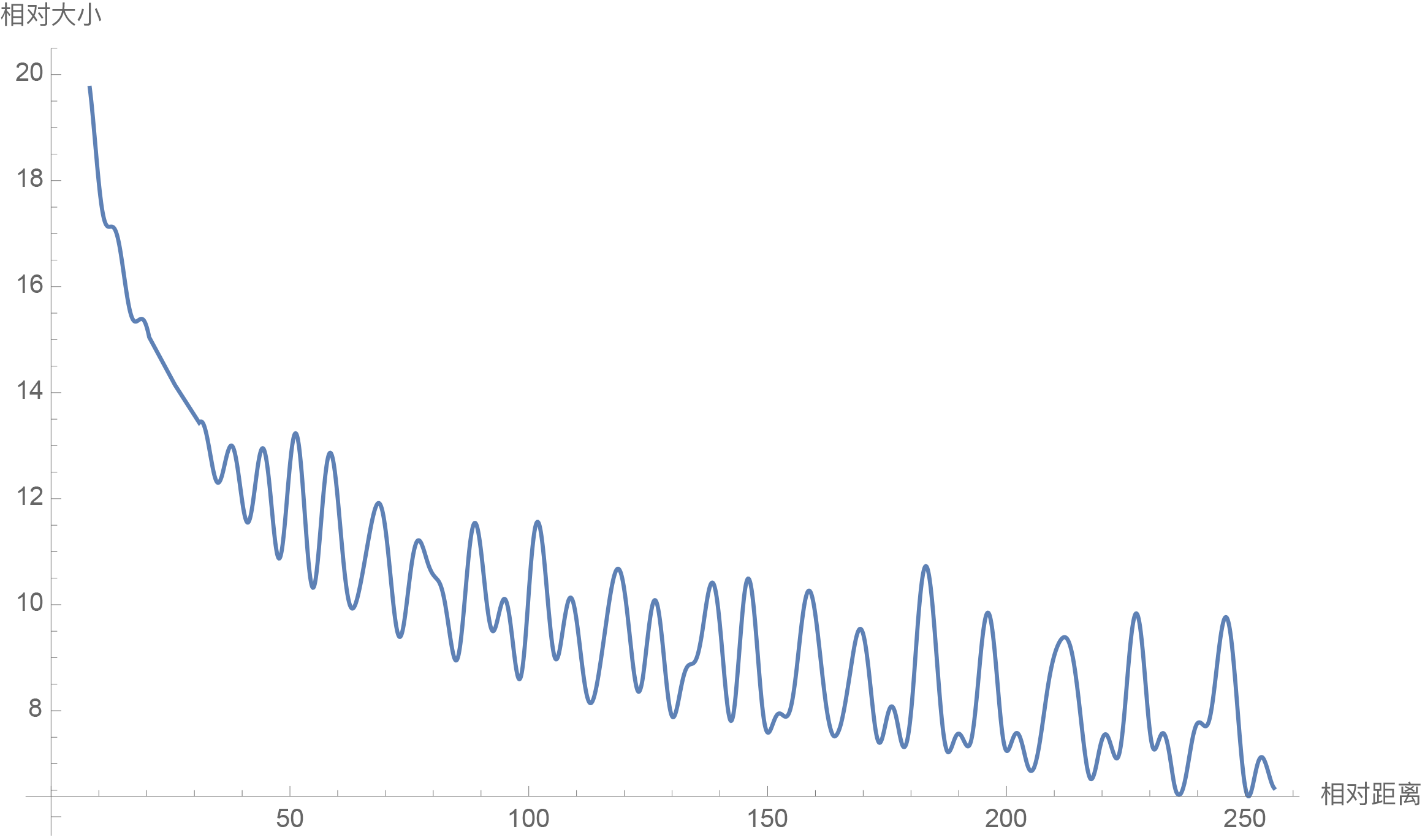

因此我们可以考察$\frac{1}{d/2}\sum\limits_{i=1}^{d/2} |S_i|$随着相对距离的变化情况来作为衰减性的体现,Mathematica代码如下:

d = 128;

\[Theta][t_] = 10000^(-2*t/d);

f[m_] = Sum[

Norm[Sum[Exp[I*m*\[Theta][i]], {i, 0, j}]], {j, 0, d/2 - 1}]/(d/2);

Plot[f[m], {m, 0, 256}, AxesLabel -> {相对距离, 相对大小}]结果如下图:

从图中我们可以可以看到随着相对距离的变大,内积结果有衰减趋势的出现。因此,选择$\theta_i = 10000^{-2i/d}$,确实能带来一定的远程衰减性。当然,同上一篇文章说的一样,能带来远程衰减性的不止这个选择,几乎任意的光滑单调函数都可以,这里只是沿用了已有的选择而已。笔者还试过以$\theta_i = 10000^{-2i/d}$为初始化,将$\theta_i$视为可训练参数,然后训练一段时间后发现$\theta_i$并没有显著更新,因此干脆就直接固定$\theta_i = 10000^{-2i/d}$了。

线性场景 #

最后,我们指出,RoPE是目前唯一一种可以用于线性Attention的相对位置编码。这是因为其他的相对位置编码,都是直接基于Attention矩阵进行操作的,但是线性Attention并没有事先算出Attention矩阵,因此也就不存在操作Attention矩阵的做法,所以其他的方案无法应用到线性Attention中。而对于RoPE来说,它是用绝对位置编码的方式来实现相对位置编码,不需要操作Attention矩阵,因此有了应用到线性Attention的可能性。

关于线性Attention的介绍,这里不再重复,有需要的读者请参考《线性Attention的探索:Attention必须有个Softmax吗?》。线性Attention的常见形式是:

\begin{equation}Attention(\boldsymbol{Q},\boldsymbol{K},\boldsymbol{V})_i = \frac{\sum\limits_{j=1}^n \text{sim}(\boldsymbol{q}_i, \boldsymbol{k}_j)\boldsymbol{v}_j}{\sum\limits_{j=1}^n \text{sim}(\boldsymbol{q}_i, \boldsymbol{k}_j)} = \frac{\sum\limits_{j=1}^n \phi(\boldsymbol{q}_i)^{\top} \varphi(\boldsymbol{k}_j)\boldsymbol{v}_j}{\sum\limits_{j=1}^n \phi(\boldsymbol{q}_i)^{\top} \varphi(\boldsymbol{k}_j)}\end{equation}

其中$\phi,\varphi$是值域非负的激活函数。可以看到,线性Attention也是基于内积的,所以很自然的想法是可以将RoPE插入到内积中:

\begin{equation}\frac{\sum\limits_{j=1}^n [\boldsymbol{\mathcal{R}}_i\phi(\boldsymbol{q}_i)]^{\top} [\boldsymbol{\mathcal{R}}_j\varphi(\boldsymbol{k}_j)]\boldsymbol{v}_j}{\sum\limits_{j=1}^n [\boldsymbol{\mathcal{R}}_i\phi(\boldsymbol{q}_i)]^{\top} [\boldsymbol{\mathcal{R}}_j\varphi(\boldsymbol{k}_j)]}\end{equation}

但这样存在的问题是,内积$[\boldsymbol{\mathcal{R}}_i\phi(\boldsymbol{q}_i)]^{\top} [\boldsymbol{\mathcal{R}}_j\varphi(\boldsymbol{k}_j)]$可能为负数,因此它不再是常规的概率注意力,而且分母有为0的风险,可能会带来优化上的不稳定。考虑到$\boldsymbol{\mathcal{R}}_i,\boldsymbol{\mathcal{R}}_j$都是正交矩阵,它不改变向量的模长,因此我们可以抛弃常规的概率归一化要求,使用如下运算作为一种新的线性Attention:

\begin{equation}\frac{\sum\limits_{j=1}^n [\boldsymbol{\mathcal{R}}_i\phi(\boldsymbol{q}_i)]^{\top} [\boldsymbol{\mathcal{R}}_j\varphi(\boldsymbol{k}_j)]\boldsymbol{v}_j}{\sum\limits_{j=1}^n \phi(\boldsymbol{q}_i)^{\top} \varphi(\boldsymbol{k}_j)}\end{equation}

也就是说,RoPE只插入分子中,而分母则不改变,这样的注意力不再是基于概率的(注意力矩阵不再满足非负归一性),但它某种意义上来说也是一个归一化方案,而且也没有证据表明非概率式的注意力就不好(比如Nyströmformer也算是没有严格依据概率分布的方式构建注意力),所以我们将它作为候选方案之一进行实验,而我们初步的实验结果显示这样的线性Attention也是有效的。

此外,笔者在《线性Attention的探索:Attention必须有个Softmax吗?》中还提出过另外一种线性Attention方案:$\text{sim}(\boldsymbol{q}_i, \boldsymbol{k}_j) = 1 + \left( \frac{\boldsymbol{q}_i}{\Vert \boldsymbol{q}_i\Vert}\right)^{\top}\left(\frac{\boldsymbol{k}_j}{\Vert \boldsymbol{k}_j\Vert}\right)$,它不依赖于值域的非负性,而RoPE也不改变模长,因此RoPE可以直接应用于此类线性Attention,并且不改变它的概率意义。

模型开源 #

RoFormer的第一版模型,我们已经完成训练并开源到了Github中:

简单来说,RoFormer是一个绝对位置编码替换为RoPE的WoBERT模型,它跟其他模型的结构对比如下:

\begin{array}{c|cccc}

\hline

& \text{BERT} & \text{WoBERT} & \text{NEZHA} & \text{RoFormer} \\

\hline

\text{token单位} & \text{字} & \text{词} & \text{字} & \text{词} & \\

\text{位置编码} & \text{绝对位置} & \text{绝对位置} & \text{经典式相对位置} & \text{RoPE}\\

\hline

\end{array}

在预训练上,我们以WoBERT Plus为基础,采用了多个长度和batch size交替训练的方式,让模型能提前适应不同的训练场景:

\begin{array}{c|ccccc}

\hline

& \text{maxlen} & \text{batch size} & \text{训练步数} & \text{最终loss} & \text{最终acc}\\

\hline

1 & 512 & 256 & 20\text{万} & 1.73 & 65.0\%\\

2 & 1536 & 256 & 1.25\text{万} & 1.61 & 66.8\%\\

3 & 256 & 256 & 12\text{万} & 1.75 & 64.6\%\\

4 & 128 & 512 & 8\text{万} & 1.83 & 63.4\%\\

5 & 1536 & 256 & 1\text{万} & 1.58 & 67.4\%\\

6 & 512 & 512 & 3\text{万} & 1.66 & 66.2\%\\

\hline

\end{array}

从表格还可以看到,增大序列长度,预训练的准确率反而有所提升,这侧面体现了RoFormer长文本语义的处理效果,也体现了RoPE具有良好的外推能力。在短文本任务上,RoFormer与WoBERT的表现类似,RoFormer的主要特点是可以直接处理任意长的文本。下面是我们在CAIL2019-SCM任务上的实验结果:

\begin{array}{c|cc}

\hline

& \text{验证集} & \text{测试集} \\

\hline

\text{BERT-512} & 64.13\% & 67.77\% \\

\text{WoBERT-512} & 64.07\% & 68.10\% \\

\text{RoFormer-512} & 64.13\% & 68.29\% \\

\text{RoFormer-1024} & \textbf{66.07%} & \textbf{69.79%} \\

\hline

\end{array}

其中$\text{-}$后面的参数是微调时截断的maxlen,可以看到RoFormer确实能较好地处理长文本语义,至于设备要求,在24G显存的卡上跑maxlen=1024,batch_size可以跑到8以上。目前中文任务中笔者也就找到这个任务比较适合作为长文本能力的测试,所以长文本方面只测了这个任务,欢迎读者进行测试或推荐其他评测任务。

当然,尽管理论上RoFormer能处理任意长度的序列,但目前RoFormer还是具有平方复杂度的,我们也正在训练基于线性Attention的RoFormer模型,实验完成后也会开源放出,请大家期待。

(注:RoPE和RoFormer已经整理成文《RoFormer: Enhanced Transformer with Rotary Position Embedding》提交到了Arxiv,欢迎使用和引用哈哈~)

文章小结 #

本文介绍了我们自研的旋转式位置编码RoPE以及对应的预训练模型RoFormer。从理论上来看,RoPE与Sinusoidal位置编码有些相通之处,但RoPE不依赖于泰勒展开,更具严谨性与可解释性;从预训练模型RoFormer的结果来看,RoPE具有良好的外推性,应用到Transformer中体现出较好的处理长文本的能力。此外,RoPE还是目前唯一一种可用于线性Attention的相对位置编码。

转载到请包括本文地址:https://kexue.fm/archives/8265

更详细的转载事宜请参考:《科学空间FAQ》

如果您还有什么疑惑或建议,欢迎在下方评论区继续讨论。

如果您觉得本文还不错,欢迎分享/打赏本文。打赏并非要从中获得收益,而是希望知道科学空间获得了多少读者的真心关注。当然,如果你无视它,也不会影响你的阅读。再次表示欢迎和感谢!

如果您需要引用本文,请参考:

苏剑林. (Mar. 23, 2021). 《Transformer升级之路:2、博采众长的旋转式位置编码 》[Blog post]. Retrieved from https://kexue.fm/archives/8265

@online{kexuefm-8265,

title={Transformer升级之路:2、博采众长的旋转式位置编码},

author={苏剑林},

year={2021},

month={Mar},

url={\url{https://kexue.fm/archives/8265}},

}

August 31st, 2023

这里的旋转矩阵Rm=R1^m,这样是不是可以直接用模型去训练R1,R1属于SO(d)

是,但正如本文提到,我尝试过将$\theta$初始化为$\theta_i = 10000^{-2i/d}$后改为可训练参数,发现结果几乎没变化,所以保留了固定参数的形式。

October 4th, 2023

rope的外推能力优于Sinusoidal吗?还是说理论上相对位置编码的外推性都是差不多的?

好也好不了多少

再请教下,看rope的远程衰减性有几个问题:

1. 位置越远,影响越小,那么是不是从一定程度上说,其实我们不需要无限长度的外推性质?一个足够大的窗口已经可以满足需求。

2. rope相对距离越远,较于Sinusoidal震荡的非常明显,这种震荡会影响长序列位置建模的效果吗?

3. 从远程衰减的图像看,相对距离越远,越趋向于饱和,梯度变小,会不会限制长序列下位置信息表达的差异性?这个曲线更加接近线性对长序列会更好吗

1、衰减其实其实一种整体趋势,而且只是相对近邻距离的attention来说的,不排除个别远距离token的attention也很大;

2、震荡在RoPE和Sinusoidal都存在吧,其实不用过于担心细节(也担心不来),只需要赋予模型相对位置的能力,那么剩下来的交给模型和优化器就好。

3、注意衰减的下降并不是负无穷,而是0附近的值,对应的注意力也不是绝对等于零,所以理论上不存在大问题,至于线性不一定更好,alibi就是线性。

October 18th, 2023

苏老师您好,我在实验中发现如果将所有token的位置下标平移1000位,模型输出会有微小差异,我对此感到困惑,所以想向您求证“RoPE作为相对位置编码是否应该具有平移不变性”?

由于RoPE是以绝对位置编码的方式实现,qk会分别进行旋转再求点积,所以或许这种微小差异可能是由于推理时精度有限导致的差异?

推理精度是fp32还是fp16?以及微小差异是多大?

平移不变性理论性质,数值计算本身有各种误差。

October 22nd, 2023

神无敌。

November 5th, 2023

苏神,$\boldsymbol{g} (\boldsymbol{q}, \boldsymbol{k}, m-n) $是个实数吧。那下面这个式子还要满足辅角等于0 \begin{equation}\begin{aligned}

\Theta_f (\boldsymbol{q}, m) - \Theta_f (\boldsymbol{k}, n) =&\, \Theta_g (\boldsymbol{q}, \boldsymbol{k}, m-n)

\end{aligned}\end{equation}

也就是\begin{equation}\begin{aligned}

\Theta_f (\boldsymbol{q}, m) - \Theta_f (\boldsymbol{k}, n) =&\, 0

\end{aligned}\end{equation}

取$m=n=0$,则\begin{equation}\begin{aligned}

\Theta_f (\boldsymbol{q}) - \Theta_f (\boldsymbol{k}) =&\, 0

\end{aligned}\end{equation}

这个式子对于任意的$q,k$都成立,似乎不可能吧?不知道我有没有理解错,望解答!

$\boldsymbol{g}$不是$g$,$g$是实数,$\boldsymbol{g}$是复数。

November 17th, 2023

苏神,这两天有一篇针对RoPE进行改进的工作,《CoCA: Fusing position embedding with Collinear Constrained Attention for fine-tuning free context window extending》

Figure 2中的思想我没太看懂,苏神对这个想法怎么看?

CoCA刚出来那会我就跟作者交流过,其实就是简化了Attention的设计,确保了$\boldsymbol{q}_i$与$\boldsymbol{k}_i$的注意力尽可能是最大的,从而让注意力出现局域性,继而出现长度外推性,我不是很看好这种局域的思路,测了一下结果也不算特别好。而且这样一来不增加计算量的话,Q、K的等效head_size实质更低(或者要增加计算量保持维度不变),感觉拟合能力有局限。

December 12th, 2023

苏神好,最近看到了很多关于rotary embedding不同的实现方式,对于有些实现方式众说纷纭,有个疑问向你求证一下。

因为最后是在点积结果中得到这种相对关系,那么实际上选择的构成相对关系的组合维度是可以任意两两组合的吧?例如对于 [0,1,2,3,4,5]六个dim,您文章中是按照两两相邻的方式构成组合,那么实现中对于(0,3),(1,4),(2,5)这样的组合方式应该是同样能得到相对位置的表示能力吧?

是的,不同的配对方式本质上不影响模型的表达能力,并且可以相互转化。

不知道这里的相互转化具体是指?

简单来说,就是一个形式训练出来的模型权重,稍加处理后可以用另一个形式的模型代码加载,结果100%等价。

February 27th, 2024

苏神消融过 RoPE 在不同层插入的效果吗?比如只在第一层插入,原 paper 中好像没看到这样的消融实验

没试过,因为这样就多了超参,感觉没必要

March 20th, 2024

苏神你好,我尝试对rope做了一些测试以及对应用rope之后的attention结果做了展开,发现有一些东西我不是太理解,来请教下你~

1. 随机初始化两个特征向量Q和K, 设定他们的postion位置m和n, 先计算Q和K的原始内积, 然后再测试不同n的情况下,应用了rope后的内积结果:

随着相对距离变远, 应用rope后的内积大体是衰减的,但到后面有明显的振荡, 甚至会大于原始内积的结果.

2. 对应用rope之后的attention结果做展开

原始Q,K的特征维度分成两部分

Q= [Q1, Q2], K= [K1,K2]

应用rope后

Q= [Q1*cos(m) - Q2*sin(m), Q2*cos(m) + Q1*sin(m)]

K= [K1*cos(n) - K2*sin(n), K2*cos(n) + K1*sin(n)]

att= cos(m-n)*(Q1*K1+ Q2*K2) + (Q1*K2-Q2*K1)*sin(n-m)

到这里我有两个疑惑:

1) Q1*K1+ Q2*K2是原始内积结果, 那么上述 Q1*K2-Q2*K1的意义是什么呢

2) 由于rope中也用了sinusoidal的角度编码, 由于每个特征维度的角度freq是不一样的, 总内积等于每个维度特征的内积加权后的结果, 相对位置不同,每个维度特征的权重不一样.

所以,我的问题是:

1. 是不是可以不用 sinusoidal角度编码那一套, 所有维度的角度freq都取1.0/base?

2. Q1==Q2, K1==K2的情况下, 上述att= cos(m-n)*(Q1*K1+ Q2*K2), 稳定的满足远程衰减啊, 对应的让Q=[Q*0.5, Q*0.5], K=[K,K]即可, 请问这种方式你觉得可行嘛?

对于rope的作用, 个人认为是通过对Q和K进行位置编码,使得编码后的Q和K在计算内积的时候, 隐含了距离衰减, 但省区了attention层面操作, 像上述att= cos(m-n)*(Q1*K1+ Q2*K2) 这种就感觉是一个很理想的方式呀,这里会有别的考量不,想听下你这边的看法.

> Q1*K1+ Q2*K2是原始内积结果, 那么上述 Q1*K2-Q2*K1的意义是什么呢

好像也没有规定原始内积就一定是有意义的,非内积就没意义?所以为什么要分开解释?

> 是不是可以不用 sinusoidal角度编码那一套, 所有维度的角度freq都取1.0/base?

不可以,效果会很差,而且也没有了远程衰减的特性了

> Q1==Q2, K1==K2的情况下, 上述att= cos(m-n)*(Q1*K1+ Q2*K2), 稳定的满足远程衰减啊, 对应的让Q=[Q*0.5, Q*0.5], K=[K,K]即可, 请问这种方式你觉得可行嘛?

cos(m-n)显然不是单调远程衰减函数...不过类似的研究是有的,参考CoCA:https://arxiv.org/abs/2309.08646 ,还有之前知乎的专栏文章:https://zhuanlan.zhihu.com/p/634491363

March 29th, 2024

[...]在这个系列的第二篇文章《Transformer升级之路:2、博采众长的旋转式位置编码》中,笔者提出了旋转位置编码(RoPE)——通过绝对位置的形式实现相对位置编码的方案。一开始RoPE是针对一维序列如文本、音频等设计的(RoPE-1D),后来在《Transformer升级之路:4、二维位置的旋转式位置编码》中我们将它推广到了二维序列(RoPE-2D),这适用于图像的ViT。然而,不管是RoPE-1[...]