基于CNN和序列标注的对联机器人

By 苏剑林 | 2019-01-14 | 51259位读者 |缘起 #

前几天在量子位公众号上看到了《这个脑洞清奇的对联AI,大家都玩疯了》一文,觉得挺有意思,难得的是作者还整理并公开了数据集,所以决定自己尝试一下。

动手 #

“对对联”,我们可以看成是一个句子生成任务,可以用seq2seq完成,跟笔者之前写的《玩转Keras之seq2seq自动生成标题》一样,稍微修改一下输入即可。上面提到的文章所用的方法也是seq2seq,可见这算是标准做法了。

分析 #

然而,我们再细想一下就会发现,相对于一般的句子生成任务,“对对联”有规律得多:1、上联和下联的字数一样;2、上联和下联的每一个字几乎都有对应关系。如此一来,其实对对联可以直接看成一个序列标注任务,跟分词、命名实体识别等一样的做法即可。这便是本文的出发点。

说到这,其实本文就没有什么技术含量了,序列标注已经是再普通不过的任务了,远比一般的seq2seq来得简单。所谓序列标注,就是指输入一个向量序列,然后输出另外一个通常长度的向量序列,最后对这个序列的“每一帧”进行分类。相关概念来可以在《简明条件随机场CRF介绍(附带纯Keras实现)》一文进一步了解。

模型 #

本文直接边写代码边介绍模型。如果需要进一步了解背后的基础知识的读者,还可以参考《【中文分词系列】 4. 基于双向LSTM的seq2seq字标注》、《【中文分词系列】 6. 基于全卷积网络的中文分词》、《基于CNN和VAE的作诗机器人:随机成诗》。

我们所用的模型代码如下:

x_in = Input(shape=(None,))

x = x_in

x = Embedding(len(chars)+1, char_size)(x)

x = Dropout(0.25)(x)

x = gated_resnet(x)

x = gated_resnet(x)

x = gated_resnet(x)

x = gated_resnet(x)

x = gated_resnet(x)

x = gated_resnet(x)

x = Dense(len(chars)+1, activation='softmax')(x)

model = Model(x_in, x)

model.compile(loss='sparse_categorical_crossentropy',

optimizer='adam')其中gated_resnet是笔者定义的门卷积模块(在《基于CNN的阅读理解式问答模型:DGCNN》一文也介绍过这个模块):

def gated_resnet(x, ksize=3):

# 门卷积 + 残差

x_dim = K.int_shape(x)[-1]

xo = Conv1D(x_dim*2, ksize, padding='same')(x)

return Lambda(lambda x: x[0] * K.sigmoid(x[1][..., :x_dim]) \

+ x[1][..., x_dim:] * K.sigmoid(-x[1][..., :x_dim]))([x, xo])仅此而已~

就这样完了,剩下的都是数据预处理的事情了。当然,读者也可以尝试也可以把gated_resnet换成普通的双向LSTM,但我实验中发现双向LSTM并没有gated_resnet效果好,而且LSTM相对来说也更慢,所以LSTM在这里就被抛弃了。

效果 #

训练的数据集来自:https://github.com/wb14123/couplet-dataset,感谢作者的整理。

完整代码:

https://github.com/bojone/seq2seq/blob/master/couplet_by_seq_tagging.py

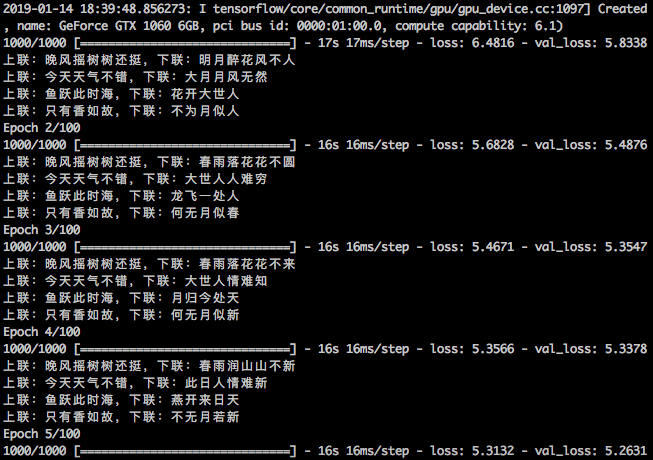

训练过程:

部分效果:

上联:晚风摇树树还挺,下联:夜雨敲花花更香

上联:今天天气不错,下联:昨日人情无明

上联:鱼跃此时海,下联:鸟鸣何日人

上联:只有香如故,下联:不无月若新

上联:科学空间,下联:文明大中

看起来还是有点味道的。注意“晚风摇树树还挺”是训练集的上联,标准下联是“晨露润花花更红”,而模型给出来的是“夜雨敲花花更香”,说明模型并不是单纯地记住训练集的,还是有一定的理解能力;甚至我觉得模型对出来的下联更生动一些。

总的来说,基本的字的对应似乎都能做到,就缺乏一个整体感。总体效果没有下面两个好,但作为一个小玩具,应该能让人满意了。

王斌版AI对联:https://ai.binwang.me/couplet/

结语 #

最后,也没有什么好总结的。我就是觉得这个对对联应该算是一个序列标注任务,所以就想着用一个序列标注的模型来试试看,结果感觉还行~当然,要做得更好,需要在模型上做些调整,还可以考虑引入Attention等,然后解码的时候,还需要引入更多的先验知识,保证结果符合我们对对联的要求。这些就留给有兴趣做下去的读者继续了。

转载到请包括本文地址:https://kexue.fm/archives/6270

更详细的转载事宜请参考:《科学空间FAQ》

如果您还有什么疑惑或建议,欢迎在下方评论区继续讨论。

如果您觉得本文还不错,欢迎分享/打赏本文。打赏并非要从中获得收益,而是希望知道科学空间获得了多少读者的真心关注。当然,如果你无视它,也不会影响你的阅读。再次表示欢迎和感谢!

如果您需要引用本文,请参考:

苏剑林. (Jan. 14, 2019). 《基于CNN和序列标注的对联机器人 》[Blog post]. Retrieved from https://kexue.fm/archives/6270

@online{kexuefm-6270,

title={基于CNN和序列标注的对联机器人},

author={苏剑林},

year={2019},

month={Jan},

url={\url{https://kexue.fm/archives/6270}},

}

你也许还对下面的内容感兴趣

- 《为什么现在的LLM都是Decoder-only的架构?》FAQ

- 为什么现在的LLM都是Decoder-only的架构?

- GPLinker:基于GlobalPointer的事件联合抽取

- GPLinker:基于GlobalPointer的实体关系联合抽取

- Efficient GlobalPointer:少点参数,多点效果

- 曾被嫌弃的预训练任务NSP,做出了优秀的Zero Shot效果

- 用开源的人工标注数据来增强RoFormer-Sim

- SimBERTv2来了!融合检索和生成的RoFormer-Sim模型

- GlobalPointer:用统一的方式处理嵌套和非嵌套NER

- P-tuning:自动构建模版,释放语言模型潜能

January 25th, 2019

曾尝试实现过《基于CNN的阅读理解式问答模型:DGCNN》一文中的门卷积模块,对比之下发现苏神的设计思路十分精妙。同时想问一下苏神,为什么在这篇文章中没有使用膨胀卷积和正则化手段呢,如何抉择是否使用膨胀卷积是取决于运算代价吗?

对联一般不到10个字,用不着膨胀,长文本才用膨胀...

正则化?你是说那个droppath?我这里比较简单,用普通的dropout足矣。

谢谢苏神解答~还想问一下,如果是在普通文本分类问题中使用门卷积机制替代LSTM并引入Attention的话,还可以通过可视化权重来判断Attention效果么?如果可以的话是怎样的思路呢

你可以可视化attention的权重,只要你会就行了,可视化的效果图,可以参考《Attention is all you need》那篇论文。

May 8th, 2019

[...]参考: https://kexue.fm/archives/6270 https://blog.csdn.net/sinat_26917383/article/details/75050225[...]