捉弄计划的失败——单摆周期

By 苏剑林 | 2010-06-09 | 46630位读者 | 引用“滴答滴答,滴答滴答——”当我们看到家里的摆钟来回摆动,并且能够准确地报时的时候,有没有想过其中的奥妙呢?

有一天,你想捉弄一下妈妈,把钟摆系上一个重物,心想着钟一定会走得更快,妈妈就会乱套了。可是很快你会失望地发现,摆钟依然准时地走着,没有任何异常,时间仿佛在宣告他的不可控制。你感到非常纳闷:为什么我的计划会失败呢?

据说,世界上第一个研究单摆的人是伽利略,他通过多次实验得出结论:单摆的周期只取决于摆绳的长度,和摆的重量无关。这是你明白了,原来要捉弄妈妈,应该要增加钟摆长度才对...^_^

现在我们来分析一下这个单摆....

三次方程的三角函数解法

By 苏剑林 | 2010-08-08 | 90274位读者 | 引用对于解方程,代数学家希望能够从理论上证明解的存在性以及解的求法,所以就有了1到4次方程的求根公式、5次及以上的代数方程没有根式可解等重要理论;然而,通常的学者(如物理学家、天文学家)都不需要这些内容,他们只关心如何尽可能快地求出指定方程的根(尤其是实数根),所以他们通常关注的是方程的数值算法,当然,如果能有一个相对简单的求根公式,也是他们所希望的。而接下来所要介绍的内容,则是满足了这一需要的三次方程的求根公式,其中用到的相当一部分的理论,是与三角函数相关的。

储备

\begin{equation}\frac{2}{\tan 2A}=\frac{1}{\tan A}-\tan A\end{equation}

\begin{equation}\frac{2}{\sin 2A}=\frac{1}{\tan A}+\tan A\end{equation}

\begin{equation}\cos(3A)=4\cos^3 A-3\cos A\end{equation}

与向量的渊源极深的四元数

By 苏剑林 | 2010-08-27 | 34957位读者 | 引用当我们在使用向量进行几何、物理研究的时候,是否曾经想到:向量竟然起源于“数”?

当向量还没有发展起来的时候(虽然“有方向有大小的量”很早就被人们认识),复数已经得到了认可并且有了初步应用。当我们把复数跟向量联系起来时,我们也许会认为,因为复平面表示的复数运算与向量有着相似之处,才把复数跟几何联系起来。然而事实却相反,向量是从对复数乃至一种称为“四元数”的东西的研究中逐渐分离出来的。换句话说,历史中出现过“四元数”与向量分别研究几何的阶段,麦克斯韦(Maxwell) 将四元 数的数量部分和矢量部分分开,作为 实 体处理,作了大量的矢量分析。三维矢量分析的建立,及同四元数的正式分裂是18世纪80年代由Gibbs和Heaviside独立完成的。矢量代数被推广到矢量函数和矢量微积分,由此开始了四元数和矢量分析的争论,最终矢量分析占了上风。因而“四元数”渐渐离开了教科书。不过,“四元数”的一些特殊而巧妙的应用,仍然使我们不至于忘记它。

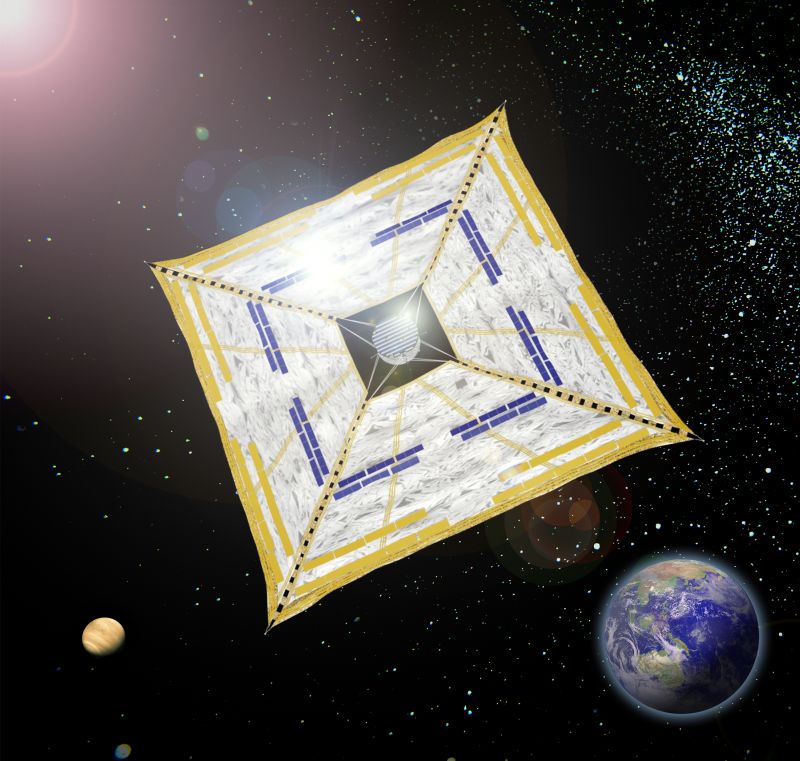

扬帆——在宇宙的海洋中航行

By 苏剑林 | 2010-10-24 | 23212位读者 | 引用费曼积分法——积分符号内取微分(2)

By 苏剑林 | 2012-06-12 | 100391位读者 | 引用上一篇文章我对“费曼积分法”做了一个简单的介绍,并通过举例来初步展示了它的操作步骤。但是,要了解一个方法,除了知道它能够干什么之外,还必须了解它的原理和方法,这样我们才能够更好地掌握它。因此,我们需要建立“积分符号内取微分”的一般理论,为进一步的应用奠基。

一般原理

我们记

$$G(a)=\int_{m(a)}^{n(a)} f(x,a)dx$$

在这里,f(x,a)是带有参数a的关于x的函数,而积分区间是关于参数a的两个函数,这样的积分也叫变限积分,可以理解为是普通定积分的推广。我们记F(x,a)为f(x,a)的原函数,也就是说$\frac{\partial F(x,a)}{\partial x}=f(x,a)$,那么按照微积分基本定理,我们就有:

$$G(a)=F(n(a),a)-F(m(a),a)$$

《新理解矩阵2》:矩阵是什么?

By 苏剑林 | 2012-10-31 | 39496位读者 | 引用上一篇文章中我从纯代数运算的角度来讲述了我对矩阵的一个理解,可以看到,我们赋予了矩阵相应的运算法则,它就在代数、分析等领域显示出了巨大作用。但是纯粹的代数是不足够的,要想更加完美,最好是找到相应的几何对象能够与之对应,只有这样,我们才能够直观地理解它,以达到得心应手的效果。

几何理解

我假设读者已经看过孟岩的《理解矩阵》三篇文章,所以更多的细节我就不重复了。我们知道,矩阵A

$$\begin{pmatrix}a_{11} & a_{12} \\ a_{21} & a_{22}\end{pmatrix}$$

事实上由两个向量$[a_{11},a_{21}]^T$和$[a_{12},a_{22}]^T$(这里的向量都是列向量)组成,它描述了一个平面(仿射)坐标系。换句话说,这两个向量其实是这个坐标系的两个基,而运算$y=Ax$则是告诉我们,在$A$这个坐标系下的x向量,在$I$坐标系下是怎样的。这里的$I$坐标系就是我们最常用的直角坐标系,也就是说,任何向量(包括矩阵里边的向量),只要它前面没有矩阵作用于它,那么它都是在直角坐标系下度量出来的。

也许中学老师会告诉5、10、20等等的十进制数字怎么化成二进制数字,但又没有老师告诉你怎么将十进制的0.1变成二进制的小数呢?

我们将一个十进制整数化为二进制是这样操作的:在十进制的计算法则中,将十进制数除以2,得到商和余数;把商除以2,得到商和余数;...重复下去,直到商为0。然后把每次得到的余数按倒序排列,就得到了二进制数字。比如6:

$$\begin{aligned}6\div 2=3...0 \\ 3\div 2=1...1 \\ 1\div 2=0...1\end{aligned}$$

倒过来就是110。这就是二进制中的6了。

最近评论