这个星期对微分方程的认识

By 苏剑林 | 2010-11-06 | 37887位读者 | 引用这个星期研究了两道微分方程问题:“导弹跟踪”以及“太阳炉”问题。从中我加深了对微分方程的理解,也熟悉了微分方程的相关运算。仅此记录,权当抛砖引玉。

一、微分方程的本质

很多读者都知道,自从牛顿和莱布尼兹发明微积分之后,微积分就迅速地渗透到了几乎所有的学科,后来发展出许多出色的分支,如变分、微分方程等。众所周知,微分方程是解决很多重要问题的工具。不知道各位读者对微分及微分方程的认识如何?其实对于常微分方程而言,它的本质和我们已经学习过的代数方程一样,只不过相互之间的对应运算关系除了常规的加减乘除幂等之外,还多了两个相互关系:微分和积分。例如对于一阶微分方程$\dot{y}=f(x,y)$,也许大家都认为它是一个二元方程,其实不然,这是一个“四个未知数、三道方程”所组成的方程组,我们可以将它写成

$$dy=f(x,y)dx,y=\int dy,x=\int dx$$

薛定谔方程的启发式推导

By 苏剑林 | 2012-12-11 | 73034位读者 | 引用===聊聊天===

上个月在网上买了三本相对论教材和一本《量子力学概论》,本打算好好研究下相对论的数学体系,可是书到了之后,我却深深地被量子力学吸引住了,不停在研读。而且在研究量子力学的同时,我的线性代数和微分方程知识也增加了不少,这确实是我没有想到的。在我看来,不管是狭义相对论还是广义相对论,它本质上都是一种几何理论,你总要想象从一个参考系观测会发生什么,然后从另外一个参考系又会看到什么;而量子力学虽然对我来讲一切都是新鲜的,但是它的数学性比较强,主要是微分方程的求解和理解。我想这也是我对量子力学更感兴趣的原因吧,因为我善于代数而不善于几何。

量子力学中让我最神往的内容莫过于费曼所发明的路径积分形式。资料记载费曼用他发明的方法在一个晚上就算出了别人几个月才算出来的结果,可见路径积分形式的优越性。当然,我也清楚,这个路径积分并不简单,它涉及到了泛函积分这一非常高深的内容,对于我这个连数学分析都还没有学好的小孩来说,泛函是难以触摸的。不过,我还是尽量想办法向它靠近。为此,我还浏览到了一些不少让人兴奋的内容,比如薛定谔的方程的推导、力学-光学类比、雅可比方程等等。

很遗憾,在正统的量子力学教材中,这些让我很兴奋的内容却鲜有涉及,有的话大多数都是一笔带过的感觉。多数量子力学不会讲到路径积分,就算有也只是作为附录。对于薛定谔方程的推导,也没有涉及到。这也让我养成了一个习惯意识:书本最有趣的东西往往都是在附录。所以对于教科书,那么写得正正式式的内容我一概没有兴趣,那些附录内容才是我最喜欢读的。可是,那些让人兴奋的内容却不一定是很难的,就像下面的薛定谔方程的启发式推导,它不仅不难,而且易于理解。

===薛定谔方程===

在量子力学诞生之前,科学家已经通过实验发现光既有波动性也有粒子性,而德布罗意提出也同时具有波动性和粒子性,这些都奠定了量子力学的基础。根据量子论,一个光子的能量可以由$E=h\nu=\hbar (2\pi \nu)$,其中$\nu$是频率,$\hbar=\frac{h}{2\pi}$,h是普朗克常数,习惯记$\omega=2\pi \nu$,即$E=\hbar \omega$。

求解微分方程的李对称方法(二)

By 苏剑林 | 2013-11-26 | 24877位读者 | 引用由于重装系统时的粗心大意,笔者把《求解微分方程的李对称方法》的Word文档弄丢了,更不幸的是存有该文档的U盘也弄丢了~没办法,只好重新把这篇文章录入了。幸好之前曾把它打印成纸质版,还有旧稿可以参考。现发布《求解微分方程的李对称方法(二)》,希望能够为对李对称方法有兴趣的朋友提供些许资源。

相比(一),(二)将所有内容重新用CTex录入了,果然,$\LaTeX$才是写数学论文软件中的佼佼者,虽然是纯代码编辑,但是这正符合我追求简洁清晰的风格。在内容上,(二)增加了一阶常微分方程组的内容,并对(一)的部分细节做了修改,本文完成后就初步相对完整地叙述了一阶常微分方程组的李对称积分的思路,内容增加到了13页。而在接下来的(三)中,将会提供李代数的内容;如果有(四)的话,就会谈到李对称方法的计算机实现。希望大家会喜欢这系列文章。更期待大家的读后感(包括挑错)^_^

从马尔科夫过程到主方程(推导过程)

By 苏剑林 | 2017-10-06 | 80728位读者 | 引用主方程(master equation)是对随机过程进行建模的重要方法,它代表着马尔科夫过程的微分形式,我们的专业主要工具之一就是主方程,说宏大一点,量子力学和统计力学等也不外乎是主方程的一个特例。

然而,笔者阅读了几个著作,比如《统计物理现代教程》,还有我导师的《生物系统的随机动力学》,我发现这些著作对于主方程的推导都很模糊,他们在着力解释结果的意义,但并不说明结果的思想来源,因此其过程难以让人信服。而知乎上有人提问《如何理解马尔科夫过程的主方程的推导过程?》但没有得到很好的答案,也表明了这个事实。

马尔可夫过程

主方程是用来描述马尔科夫过程的,而马尔科夫过程可以理解为运动的无记忆性,说通俗点,就是下一刻的概率分布,只跟当前时刻有关,跟历史状态无关。用概率公式写出来就是(这里只考虑连续型概率,因此这里的$p$是概率密度):

$$\begin{equation}\label{eq:maerkefu}p(x,\tau)=\int p(x,\tau|y,t) p(y,t) dy\end{equation}$$

这里的积分区域是全空间。这里的$p(x,\tau|y,t)$称为跃迁概率,即已经确定了$t$时刻来到了$y$位置后、在$\tau$时刻达到$x$的概率密度,这个式子的物理意义是很明显的,就不多做解释了。

用热传导方程来指导自监督学习

By 苏剑林 | 2022-11-30 | 35946位读者 | 引用用理论物理来卷机器学习已经不是什么新鲜事了,比如上个月介绍的《生成扩散模型漫谈(十三):从万有引力到扩散模型》就是经典一例。最近一篇新出的论文《Self-Supervised Learning based on Heat Equation》,顾名思义,用热传导方程来做(图像领域的)自监督学习,引起了笔者的兴趣。这种物理方程如何在机器学习中发挥作用?同样的思路能否迁移到NLP中?让我们一起来读读论文。

基本方程

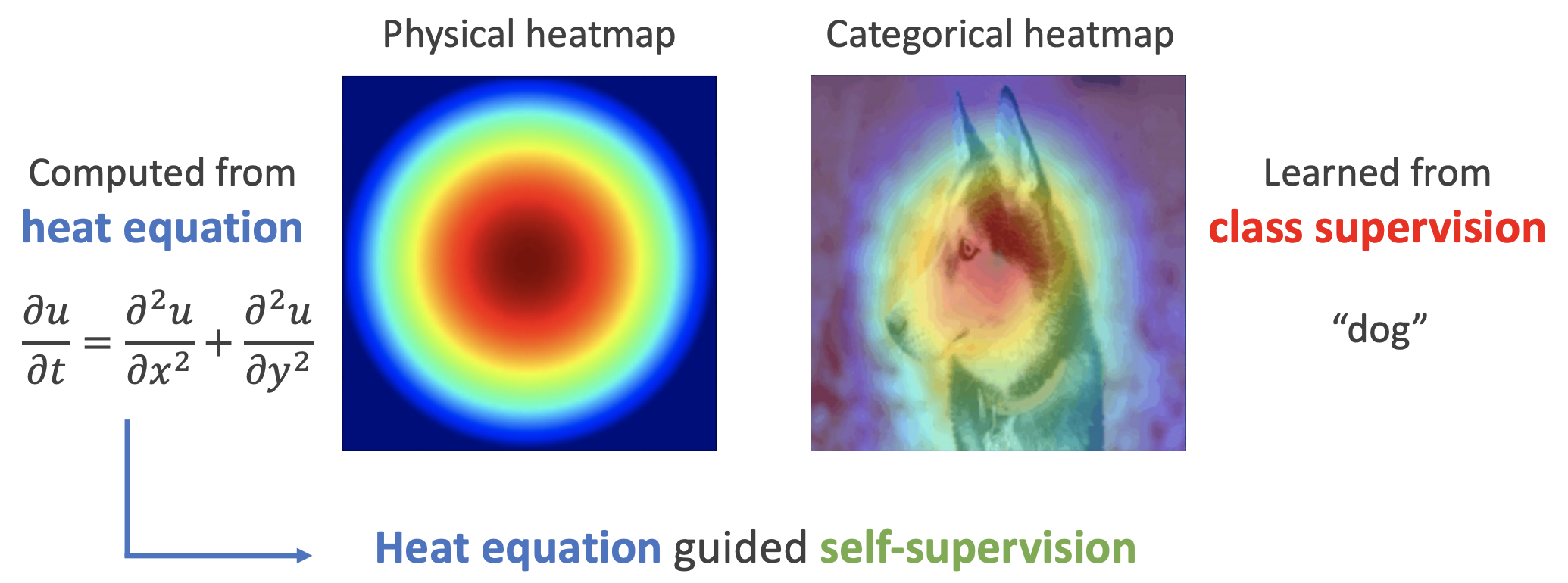

如下图,左边是物理中热传导方程的解,右端则是CAM、积分梯度等显著性方法得到的归因热力图,可以看到两者有一定的相似之处,于是作者认为热传导方程可以作为好的视觉特征的一个重要先验。

测试函数法推导连续性方程和Fokker-Planck方程

By 苏剑林 | 2023-02-11 | 44057位读者 | 引用在文章《生成扩散模型漫谈(六):一般框架之ODE篇》中,我们推导了SDE的Fokker-Planck方程;而在《生成扩散模型漫谈(十二):“硬刚”扩散ODE》中,我们单独推导了ODE的连续性方程。它们都是描述随机变量沿着SDE/ODE演化的分布变化方程,连续性方程是Fokker-Planck方程的特例。在推导Fokker-Planck方程时,我们将泰勒展开硬套到了狄拉克函数上,虽然结果是对的,但未免有点不伦不类;在推导连续性方程时,我们结合了雅可比行列式和泰勒展开,方法本身比较常规,但没法用来推广到Fokker-Planck方程。

这篇文章我们介绍“测试函数法”,它是推导连续性方程和Fokker-Planck方程的标准方法之一,其分析过程比较正规,并且适用场景也比较广。

最近评论