费曼路径积分思想的发展(一)

By 苏剑林 | 2012-12-26 | 28270位读者 | 引用注:这是郝刘祥前辈的一篇论文,98年的时候发表在《自然辩证法通讯》上,里边讲述了费曼以及路径积分的相关故事。我从网上下载下来,原文是很粗糙的pdf文件,我特意将它转化为网页文件,供大家欣赏。有些公式很模糊,所以我已经到图书馆查找了原文,但是由于作者非理论物理专业人员,还不确定部分公式是否正确,请读者慎读。原文较长,将分开几篇来发。如果涉及到版权问题,请作者告之(bojone@spaces.ac.cn),我将会尽快处理掉。

自然辩证法通讯(JOURNAL OF DIALECTICS OF NATURE)

第二十卷总115期,1998第3期

郝刘祥

摘要:该文首先阐述了 Richard Feynman为解决经典电动力学的发散问题而做的艰苦努力,进而论述了这种努力的副产品何以使他偏爱作用量表述,以及他是如何在Dirac文章的启发下得到非相对论量子力学的第三种形式--作用量量子化方案的。文章的第三部分叙述了费曼将其方案推广到相对论情形的尝试和费曼图的由来。最后,该文试图就路径积分方法在量子场论等领域中的广泛应用以及费曼对量子场论的重大疑惑作一简要的说明。

关键词:费曼,作用量,几率幅,路径积分

费曼路径积分思想的发展(三)

By 苏剑林 | 2012-12-27 | 20079位读者 | 引用3、费曼图和量子电动力学的重整化

在1947年美国避难岛(Shelter Island)会议上,兰姆报导了他的重大发现,即现今所称的兰姆位移;氢原子的$2S_{\frac{1}{2}}$能级比$2P_{\frac{1}{2}}$高出约1000MHz。而按照狄拉克理论,对纯库仑相互作用的电子-质子系统,这两个能级应该是简并的。人们很快就认识到,该位移应归之于一阶近似的辐射校正[19]。贝特用一个电子的校正质量就非相对论近似得出了氢原子nS能级的位移公:

$$\frac{8}{3\pi}(\frac{e^2}{\hbar c})Ry \frac{Z^4}{n^3} Ln\frac{K}{ < E_n-E_m > _{AV}}$$

费曼积分法(8):求高斯积分

By 苏剑林 | 2013-04-14 | 57818位读者 | 引用自从了解了费曼积分法之后,我就一直想着用费曼积分法来求高斯积分$\int_0^{\infty} e^{-x^2}dx=\frac{\sqrt{\pi}}{2}$这个神奇的积分,但一直无果。在《数学桥》里边,作者是通过将其转变为二重积分来解决的,简洁而巧妙。但是为了显示费曼积分法的威力,我一直想找到高斯积分的其他求法。上星期在《数学物理方法》中看到作者用拉普拉斯变换求出了该积分,眼睛不禁为之一亮,不过这属于积分变换内容,属于“积分符号内取积分”的技巧,在此不作讨论。今天在网上查找资料时,在“赵洁”的一篇论文《含参变量积分》中,看到了一种属于费曼积分法范畴内的方法,特与大家分享。

从“事后分析”来看,高斯积分的结果涉及到了$\sqrt{\pi}$这个量,一般来说我们常见的公式出现$\pi$的不少,可是几乎没有出现$\sqrt{\pi}$的,所以一般来说我们都将它平方。我们引入

$$f(x)=(\int_0^x e^{-t^2}dt)^2$$

视频演示:费曼的茶杯

By 苏剑林 | 2014-02-07 | 18793位读者 | 引用如何看费曼的讲义和朗道的教程?

By 苏剑林 | 2014-03-25 | 62865位读者 | 引用事实上,取这个标题,有点狂妄自大、班门弄斧的感觉。原因之一是我自己并非物理专业学生,也没有学好物理。再者,我自己也没有读过多少费曼和朗道的书,谈不上“饱读”费曼朗道,又何以指导大家呢?本文很荣幸得到了高教社的王超编辑(新浪微博 @朗道集结号 )在微信上的推荐,在此表示十分的感谢。

朗道集结号

朗道、费曼、薛定谔、泡利、狄拉克、温伯格……大师在这里等着你,微信号:ldjjhwx

但是,结合自己在阅读他们的著作的感受,以及自己学习科学的过程,谈谈我对他们的著作的看法。

什么才是最简洁的方式?

相信不少读者觉得朗道的教程比费曼的讲义要深,感觉朗道的书总有大量的数学公式,而费曼的书则轻松一些。笔者开始也有这样的感觉,但是慢慢读下去,才感到费曼的书甚至比朗道的困难。

在进入讨论之前,我们不妨先想一下:什么才是理解物理的最简洁方式?数学越复杂,就越不好吗?

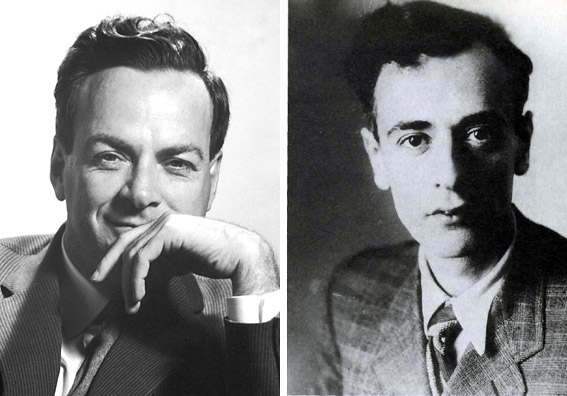

【致敬】费曼诞辰100年

By 苏剑林 | 2018-05-11 | 30426位读者 | 引用生成扩散模型漫谈(二十三):信噪比与大图生成(下)

By 苏剑林 | 2024-04-17 | 29423位读者 | 引用上一篇文章《生成扩散模型漫谈(二十二):信噪比与大图生成(上)》中,我们介绍了通过对齐低分辨率的信噪比来改进noise schedule,从而改善直接在像素空间训练的高分辨率图像生成(大图生成)的扩散模型效果。而这篇文章的主角同样是信噪比和大图生成,但做到了更加让人惊叹的事情——直接将训练好低分辨率图像的扩散模型用于高分辨率图像生成,不用额外的训练,并且效果和推理成本都媲美直接训练的大图模型!

这个工作出自最近的论文《Upsample Guidance: Scale Up Diffusion Models without Training》,它巧妙地将低分辨率模型上采样作为引导信号,并结合了CNN对纹理细节的平移不变性,成功实现了免训练高分辨率图像生成。

思想探讨

我们知道,扩散模型的训练目标是去噪(Denoise,也是DDPM的第一个D)。按我们的直觉,去噪这个任务应该是分辨率无关的,换句话说,理想情况下低分辨率图像训练的去噪模型应该也能用于高分辨率图像去噪,从而低分辨率的扩散模型应该也能直接用于高分辨率图像生成。

“熵”不起:从熵、最大熵原理到最大熵模型(二)

By 苏剑林 | 2015-12-11 | 82955位读者 | 引用上集回顾

在第一篇中,笔者介绍了“熵”这个概念,以及它的一些来龙去脉。熵的公式为

$$S=-\sum_x p(x)\log p(x)\tag{1}$$

或

$$S=-\int p(x)\log p(x) dx\tag{2}$$

并且在第一篇中,我们知道熵既代表了不确定性,又代表了信息量,事实上它们是同一个概念。

说完了熵这个概念,接下来要说的是“最大熵原理”。最大熵原理告诉我们,当我们想要得到一个随机事件的概率分布时,如果没有足够的信息能够完全确定这个概率分布(可能是不能确定什么分布,也可能是知道分布的类型,但是还有若干个参数没确定),那么最为“保险”的方案是选择使得熵最大的分布。

最大熵原理

承认我们的无知

很多文章在介绍最大熵原理的时候,会引用一句著名的句子——“不要把鸡蛋放在同一个篮子里”——来通俗地解释这个原理。然而,笔者窃以为这句话并没有抓住要点,并不能很好地体现最大熵原理的要义。笔者认为,对最大熵原理更恰当的解释是:承认我们的无知!

最近评论