《环球科学》:超越费曼图

By 苏剑林 | 2012-11-26 | 20729位读者 | 引用虽然文章的大部分内容我都还无法弄懂,但是这里边讲述的振奋人心的内容让我决定把它转载过来。文章说,将大自然的各种力统一起来,或许没有物理学家原来所想的那么困难。

撰文∕ 伯尔尼(Zvi Bern)、狄克森(Lance J. Dixon)寇索尔(David A. Kosower)

翻译∕ 高涌泉(台湾大学物理系教授)

提供/ 科学人(Scientific American繁体中文版)

重点提要

物理学家对于粒子碰撞的了解,最近经历了一场宁静革命。知名物理学家费曼所引入的观念对于很多应用而言已到达极限。作者与合作者已经发展出新的方法。

物理学家利用新方法,可以更可靠地描述在大强子对撞机(LHC)那种极端条件下普通粒子的行为,这将帮助实验学家寻找新粒子与新作用力。

新方法还有更为深刻的应用:它让一种于1980年代被物理学家放弃的统一理论有了新生命,重力看起来像是双份的强核力一起作用。

春天某个晴朗的日子,本文作者狄克森从英国伦敦地铁的茂恩都站进入地铁,想前往希斯洛机场。伦敦地铁每天有300万名乘客,他瞧着其中一位陌生人,无聊地想着:这位老兄会从温布尔登站离开地铁的机率有多大?由于此人可能搭上任何一条地铁路线,所以该如何推算这个机率呢?他想了一会,领悟到这个问题其实跟粒子物理学家所面对的麻烦很像,那就是该如何预测现代高能实验中粒子碰撞的后果。

欧洲核子研究组织(CERN)的大强子对撞机(LHC)是这个时代最重要的探索实验;它让质子以近乎光速前进并相撞,然后研究碰撞后的碎片。我们知道建造对撞机及侦测器得用上最尖端的技术,然而较不为人知的是,解释侦测器的发现同样也是极为困难的挑战。乍看之下,它不应该那么困难才对,因为基本粒子的标准模型早已确立,理论学家也一直用此模型来预测实验的结果,而且理论预测所依赖的是著名物理学家费曼(Richard P. Feynman)早在60多年前就发展出来的计算技巧,每位粒子物理学家在研究生阶段都学过费曼的技巧;关于粒子物理的每本科普书、每篇科普文章,也都借用了费曼的概念。

【通知转载】国家天文台信息技术类人才招聘

By 苏剑林 | 2010-03-23 | 18068位读者 | 引用文章来源:国家天文台

国家天文台LAMOST大科学工程面向全社会招聘信息技术类人才若干名,主要从事数据密集型天文学研究、数据库设计开发、天文应用软件服务开发、数据处理、数据挖掘、数值模拟、高性能计算、算法优化、网站网页设计维护、天文数据整理与管理、网络科普教育等工作。大天区面积多目标光纤光谱天文望远镜(LAMOST)是一项国家重大科学工程项目。该工程项目于2008年底竣工,2009年6月通过国家验收,正处于观测试运行阶段。LAMOST天文望远镜是我国已建成的最大、最先进的天文观测设备,是世界上光谱观测效率最高的望远镜,4米口径5度视场,每次可观测4000个目标,每晚可观测数万个目标,获得数十GB的数据,每年可获得数TB的科学数据。如何处理、分析、管理、发布、挖掘如此海量的数据,就是诚聘的上述人才所要面临的挑战。

Project Euler 454 :五天攻下“擂台”

By 苏剑林 | 2014-06-27 | 29903位读者 | 引用进入期末了,很多同学都开始复习了,这学期我选的几门课到现在还不是很熟悉,本想也在趁着这段时间好好看看。偏生五天前我在浏览数学研发论坛的编程擂台时看到了这样的一道题目:

设对于给定的$L$,方程

$$\frac{1}{x}+\frac{1}{y}=\frac{1}{n}$$

满足$0 < x < y \leq L$的正整数解共有$f(L)$种情况。比如$f(6)=1,f(12)=3,f(1000)=1069$,求$f(10^{12})$。

这道题目的来源是Project Euler的第454题:Diophantine reciprocals III(丢潘图倒数方程),题目简短易懂,但又不失深度,正符合我对理想题目的定义。而且最近在学习Python学习得不亦乐乎,看到这道题目就跃跃欲试。于是乎,我的五天时间就没有了,而且过程中几乎耗尽了我现在懂的所有编程技巧。由于不断地测试运行,我的电脑发热量比平时大了几倍,真是辛苦了我的电脑。最后的代码,自我感觉已经是我目前写的最精彩的代码了。在此与大家共享和共勉~

上述表达式是分式,不利于编程,由于$n=\frac{xy}{x+y}$,于是上述题目也等价于求$(x+y)|xy$(意思是$x+y$整除$xy$)的整数解。

用PyPy提高Python脚本执行效率

By 苏剑林 | 2014-06-11 | 24128位读者 | 引用在《两百万前素数之和与前两百万素数之和》中,我们用Python求了前两百万的素数和以及两百万前的素数和,并且得到了在Python 3.3中的执行时间如下:

两百万前的素数之和:

142913828922

time: 2.4048174478605646前两百万的素数之和:

31381137530481

time: 46.75734807838953

于是想办法提高python脚本的执行效率,我觉得在算法方面,优化空间已经比较小了,于是考虑执行器上的优化。在搜索的无意间我看到了一个名词——Psyco!这是python的一个外部模块,导入后可以加快.py脚本的执行。网上也有《用 Psyco 让 Python 运行得像 C一样快》、《利用 psyco 让 Python 程序执行更快》之类的文章,说明Psyco确实是一个可行的选择,于是就跃跃欲试了,后来了解到Psyco在2012年已经停止开发,只支持到Python 2.4版本,目前它由 PyPy所接替。于是我就下载了PyPy。

写在前面:作为离散数学的实验作业,我选择了研究数独。经过测试发现,数独的自动推理还不算难,我把两种常规的推理思路转化为了计算机代码,并结合了随机性推导,得到了一个解题能力还不错的数独程序。事实上,本文的程序还可以进一步优化,以得到更高能力的数独程序(只需要整理一下代码,加上几个循环和判断即可),但是我实在太懒,没有动力继续弄下去了,就这样先和大家分享吧。最后,笔者认为本文的算法是更接近我们的思维的算法。

数独简介

历史

相传数独源起于拉丁方阵(Latin Square),1970年代在美国发展,改名为数字拼图(Number Place)、之后流传至日本并发扬光大,以数学智力游戏智力拼图游戏发表。在1984年一本游戏杂志《パズル通信ニコリ》正式把它命名为数独,意思是“在每一格只有一个数字”。后来一位前任香港高等法院的新西兰籍法官高乐德(Wayne Gould)在1997年3月到日本东京旅游时,无意中发现了。他首先在英国的《泰晤士报》上发表,不久其他报纸也发表,很快便风靡全英国,之后他用了6年时间编写了电脑程式,并将它放在网站上,使这个游戏很快在全世界流行。

台湾于2005年5月由“中国时报”首度引进, 且每日连载, 亦造成很大的回响。台湾数独发展协会(Taiwan Sudoku Association, 简称 TSA)亦为世界解谜联盟会员。香港是在2005年7月30日由AM730在创刊时引入数独。中国大陆是在2007年2月28日正式引入数独。北京晚报智力休闲数独俱乐部(数独联盟前身)在新闻大厦举行加入世界谜题联合会的颁证仪式,成为世界谜题联合会的39个成员之一。(引用自“中文维基百科”: http://zh.wikipedia.org/wiki/数独)

两百万前素数之和与前两百万素数之和

By 苏剑林 | 2014-06-10 | 73937位读者 | 引用闲聊:神经网络与深度学习

By 苏剑林 | 2015-06-06 | 73854位读者 | 引用在所有机器学习模型之中,也许最有趣、最深刻的便是神经网络模型了。笔者也想献丑一番,说一次神经网络。当然,本文并不打算从头开始介绍神经网络,只是谈谈我对神经网络的个人理解。如果希望进一步了解神经网络与深度学习的朋友,请移步阅读下面的教程:

http://deeplearning.stanford.edu/wiki/index.php/UFLDL教程

http://blog.csdn.net/zouxy09/article/details/8775360

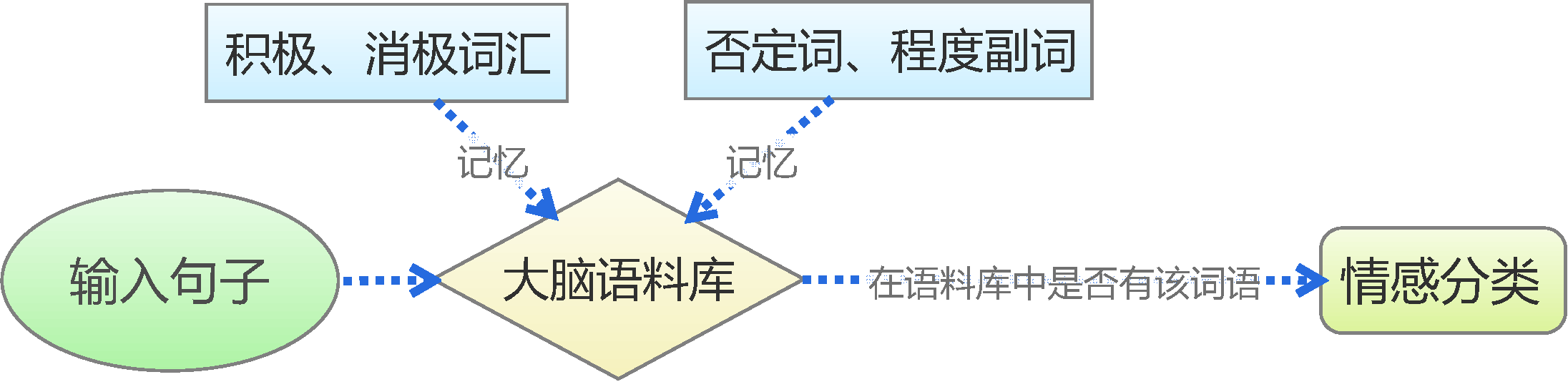

机器分类

这里以分类工作为例,数据挖掘或机器学习中,有很多分类的问题,比如讲一句话的情况进行分类,粗略点可以分类为“积极”或“消极”,精细点分为开心、生气、忧伤等;另外一个典型的分类问题是手写数字识别,也就是将图片分为10类(0,1,2,3,4,5,6,7,8,9)。因此,也产生了很多分类的模型。

文本情感分类(一):传统模型

By 苏剑林 | 2015-06-22 | 238092位读者 | 引用前言:四五月份的时候,我参加了两个数据挖掘相关的竞赛,分别是物电学院举办的“亮剑杯”,以及第三届 “泰迪杯”全国大学生数据挖掘竞赛。很碰巧的是,两个比赛中,都有一题主要涉及到中文情感分类工作。在做“亮剑杯”的时候,由于我还是初涉,水平有限,仅仅是基于传统的思路实现了一个简单的文本情感分类模型。而在后续的“泰迪杯”中,由于学习的深入,我已经基本了解深度学习的思想,并且用深度学习的算法实现了文本情感分类模型。因此,我打算将两个不同的模型都放到博客中,供读者参考。刚入门的读者,可以从中比较两者的不同,并且了解相关思路。高手请一笑置之。

最近评论